案例背景

近年來,人工智能領域發展迅速,特別是大語言模型(LLM)的崛起,極大地推動了自然語言處理技術的進步。OpenAI作為該領域的領頭羊,不斷推出創新模型,引領行業發展。其中,self-play作為一種有效的訓練策略,通過模型自我對弈來提升性能,備受關注。OpenAI最新推出的o1模型,作為多模態Self-play RL模型的代表,其在數理推理領域的卓越表現,再次引發了業界的廣泛討論。

面臨的挑戰/問題

在LLM的發展過程中,如何有效提升模型的推理能力一直是一個難題。傳統的預訓練和微調(SFT)策略雖然取得了一定的成效,但存在上限較低、成本高昂等問題。特別是在處理復雜推理任務時,模型往往難以給出準確答案。此外,隨著互聯網上語料資源的日益枯竭,如何突破現有技術的瓶頸,實現模型性能的持續提升,成為業界亟待解決的問題。

采用的策略/方法

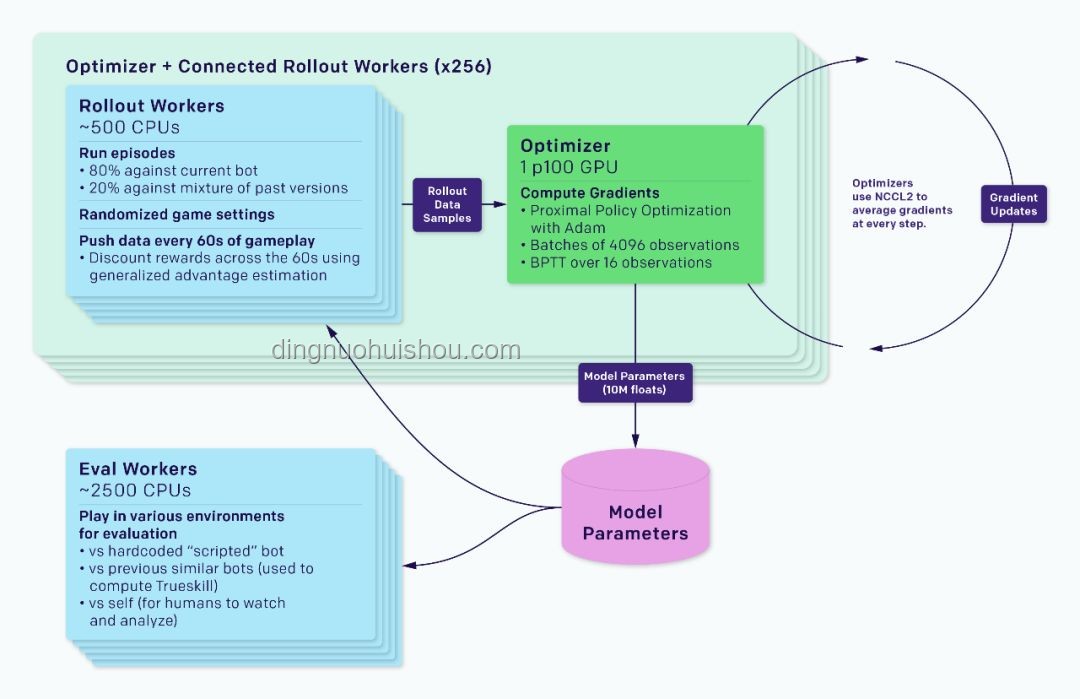

OpenAI o1模型采用了self-play RL技術路線,通過自我對弈的方式提升模型的推理能力。具體來說,o1在訓練過程中引入了強化學習(RL)機制,使模型能夠在不斷試錯中優化策略。同時,o1還提出了兩個全新的RL scaling law:train-time compute和test-time compute。這兩個定律分別描述了模型在訓練階段和推理階段的性能提升規律。

train-time compute

在訓練階段,o1通過增加強化學習的計算量來提升模型性能。這意味著模型需要在更長的訓練時間和更大的計算資源下,不斷嘗試和優化策略。這種策略有助于模型在訓練過程中學習到更復雜的推理模式,從而提升其在數理推理等任務上的表現。

test-time compute

在推理階段,o1則通過增加思考時間來提升性能。與傳統的即時響應模型不同,o1在回答用戶問題之前會進行長時間的思考。這種思考過程包括逐步提出假設、驗證思路以及反思等步驟,有助于模型在處理復雜推理任務時給出更準確的答案。

實施過程與細節

o1模型的實施過程可以分為以下幾個步驟:

- 模型架構設計:o1作為多模態模型,其架構設計充分考慮了不同模態之間的交互和融合。通過引入多模態注意力機制等先進技術,實現了文本、圖像等多種信息的有效整合。

- self-play訓練策略:在訓練過程中,o1采用了self-play策略。模型通過自我對弈的方式,不斷嘗試和優化策略。這種訓練方式有助于模型在復雜環境中學習到更高效的推理模式。

- 強化學習機制:為了提升模型的推理能力,o1引入了強化學習機制。通過設定明確的獎勵函數和懲罰機制,引導模型在訓練過程中不斷嘗試和優化策略。這種機制有助于模型在面對復雜任務時給出更準確的答案。

- 思考過程優化:在推理階段,o1通過優化思考過程來提升性能。模型在回答用戶問題之前會進行長時間的思考,逐步提出假設、驗證思路以及反思等步驟。這種思考過程有助于模型在處理復雜推理任務時給出更準確的答案。

結果與成效評估

o1模型在數理推理領域取得了顯著成績。通過self-play RL技術路線的實施,模型在多個基準測試上取得了優異成績。特別是在處理復雜推理任務時,o1展現出了強大的性能和穩定性。此外,o1還提出了兩個全新的RL scaling law,為業界提供了有價值的參考。 在具體案例中,o1模型成功解決了一個復雜的密文轉譯問題。該問題要求模型根據給定的密文到明文的映射過程,對給定的密文進行轉譯。o1模型通過長時間的思考和逐步推理,最終成功解碼出完整的信息:“THERE ARE THREE R'S IN STRAWBERRY”(草莓中有三個R)。這一案例充分展示了o1模型在復雜推理任務上的卓越表現。

經驗總結與啟示

o1模型的成功實施為業界提供了寶貴的經驗啟示:

- self-play策略的有效性:通過self-play策略,模型可以在不斷試錯中優化策略,提升性能。這種策略特別適用于處理復雜推理任務等場景。

- 強化學習機制的重要性:強化學習機制有助于引導模型在訓練過程中不斷嘗試和優化策略,從而提升模型的推理能力。

- 思考過程的優化:在推理階段,通過優化思考過程(如逐步提出假設、驗證思路以及反思等步驟),有助于模型在處理復雜任務時給出更準確的答案。

- 多模態模型的潛力:o1作為多模態模型,在整合不同模態信息方面展現出了強大的潛力。這為未來LLM的發展提供了新的思路。

綜上所述,OpenAI o1模型的self-play RL技術路線為業界提供了寶貴的經驗啟示。通過深入分析和總結其成功實施的經驗教訓,我們可以為未來LLM的發展提供有益的參考和指導。

Q&A

Q1:o1模型與GPT系列有何不同? A1:o1模型在技術路線上與GPT系列有所不同。首先,o1是一個多模態模型,而GPT系列主要關注文本信息。其次,o1采用了self-play RL技術路線,通過自我對弈的方式提升性能;而GPT系列則主要采用預訓練和微調策略。此外,o1還提出了兩個全新的RL scaling law,為業界提供了有價值的參考。 Q2:o1模型在處理復雜推理任務時有何優勢? A2:o1模型在處理復雜推理任務時展現出強大的性能和穩定性。這主要得益于其采用的self-play RL技術路線和強化學習機制。通過不斷試錯和優化策略,o1能夠在復雜環境中學習到更高效的推理模式。此外,o1在推理階段還會進行長時間的思考過程(如逐步提出假設、驗證思路以及反思等步驟),這有助于模型在處理復雜任務時給出更準確的答案。

文章評論 (1)

發表評論