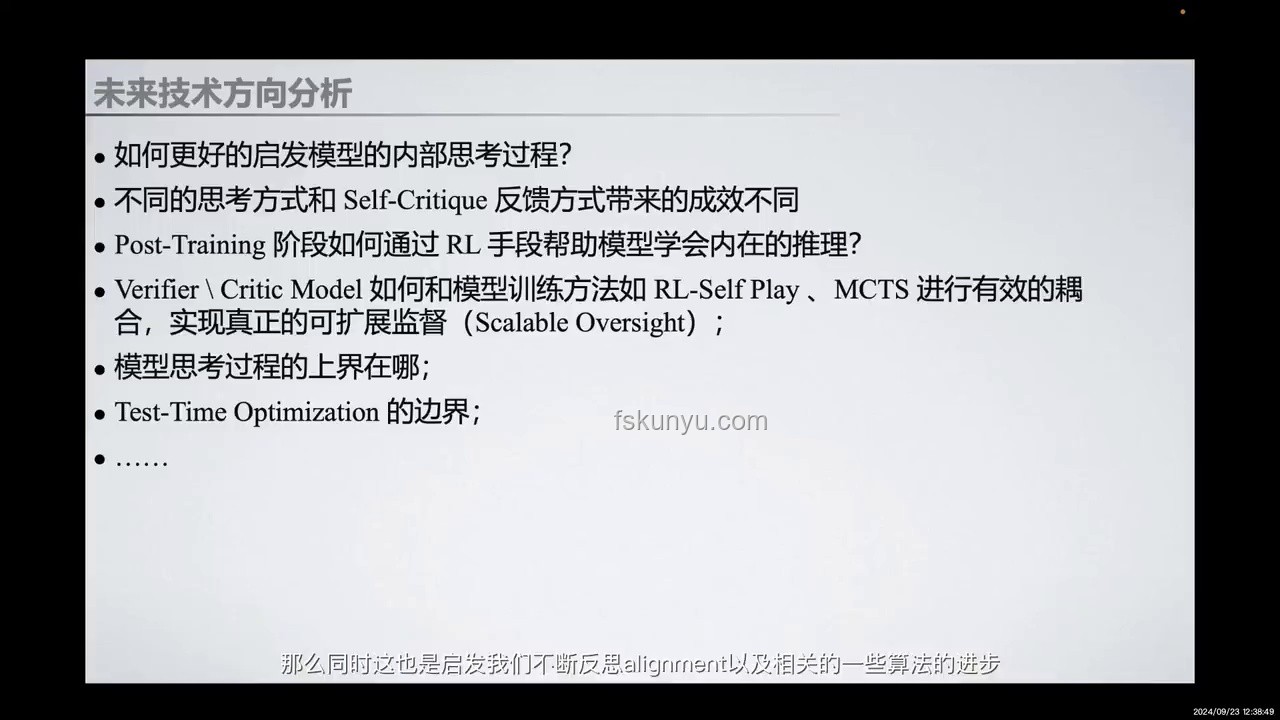

打破常規(guī)的視角:RL技術的自我進化之旅

在AI的世界里,強化學習(Reinforcement Learning, RL)一直扮演著探索未知、優(yōu)化策略的重要角色。然而,傳統(tǒng)RL技術依賴于大量人工標注數(shù)據(jù)和精心設計的獎勵函數(shù),這不僅限制了其應用范圍,也束縛了智能體的自我進化能力。OpenAI的o1自弈強化學習技術,如同一股清流,打破了這一常規(guī),開啟了智能體自我進化的新篇章。

現(xiàn)有模式的局限性:從依賴到自主

傳統(tǒng)RL技術,無論是基于模型的預測控制,還是無模型的策略梯度優(yōu)化,都高度依賴于人為設定的環(huán)境模型和獎勵機制。這不僅增加了開發(fā)成本,還可能導致智能體過度擬合特定任務,缺乏泛化能力。此外,面對復雜多變的環(huán)境,傳統(tǒng)RL往往難以找到全局最優(yōu)解,陷入局部最優(yōu)的困境。

顛覆性創(chuàng)新:o1自弈RL技術的崛起

OpenAI的o1自弈強化學習技術,以其獨特的自弈機制,顛覆了傳統(tǒng)RL技術的局限性。在自弈過程中,智能體通過模擬對弈,不斷試錯、學習和優(yōu)化策略,無需依賴外部獎勵函數(shù)或環(huán)境模型。這種無監(jiān)督的學習方式,不僅降低了對人工標注數(shù)據(jù)的依賴,還賦予了智能體更強的自適應和泛化能力。

自弈機制的魅力:從博弈到共生

自弈機制的核心在于智能體之間的博弈與共生。在自弈過程中,智能體既是競爭者也是合作者,通過不斷試錯和策略調(diào)整,共同探索更優(yōu)的解決方案。這種博弈與共生的關系,不僅促進了智能體之間的知識共享,還加速了策略的優(yōu)化進程。

跨界融合的啟示:從AI到通用智能

o1自弈強化學習技術的崛起,不僅為RL領域帶來了革命性的突破,也為跨界融合提供了新的啟示。通過將自弈機制應用于其他領域,如自然語言處理、計算機視覺等,我們可以探索出更多創(chuàng)新的技術路線和應用場景。這種跨界融合的思維,將推動AI技術向通用智能邁進。

創(chuàng)新案例:自弈機制在NLP領域的探索

在自然語言處理領域,自弈機制可以應用于對話系統(tǒng)、文本生成等任務。通過模擬對話或文本生成對弈,智能體可以不斷學習和優(yōu)化語言模型,提高生成文本的質(zhì)量和多樣性。這種自弈機制的應用,不僅降低了對大規(guī)模標注數(shù)據(jù)的依賴,還提升了智能體的語言理解和生成能力。

激發(fā)創(chuàng)意思維的實踐建議

- 嘗試自弈機制:在AI項目中引入自弈機制,通過模擬對弈來優(yōu)化策略,探索更多創(chuàng)新的應用場景。

- 跨界融合實踐:將自弈機制應用于其他領域,如NLP、CV等,探索跨界融合的新可能。

- 參與開源社區(qū):加入OpenAI等開源社區(qū),與志同道合的開發(fā)者共同探索自弈強化學習技術的未來。

培養(yǎng)創(chuàng)新能力的資源推薦

- OpenAI官網(wǎng):了解最新研究成果和技術動態(tài),參與社區(qū)討論。

- AI學術論文庫:查閱相關學術論文,深入了解自弈強化學習技術的理論基礎和實現(xiàn)方法。

- 在線課程:參加AI相關在線課程,學習強化學習、自弈機制等前沿技術。

Q&A

Q: 自弈強化學習技術是否適用于所有AI任務? A: 自弈強化學習技術適用于需要策略優(yōu)化和自適應能力的AI任務,但并不適用于所有場景。具體是否適用還需根據(jù)任務特點進行評估。 Q: 如何評估自弈強化學習技術的性能? A: 可以通過模擬對弈的勝率、策略多樣性等指標來評估自弈強化學習技術的性能。同時,也可以結合具體應用場景的需求進行定制化評估。

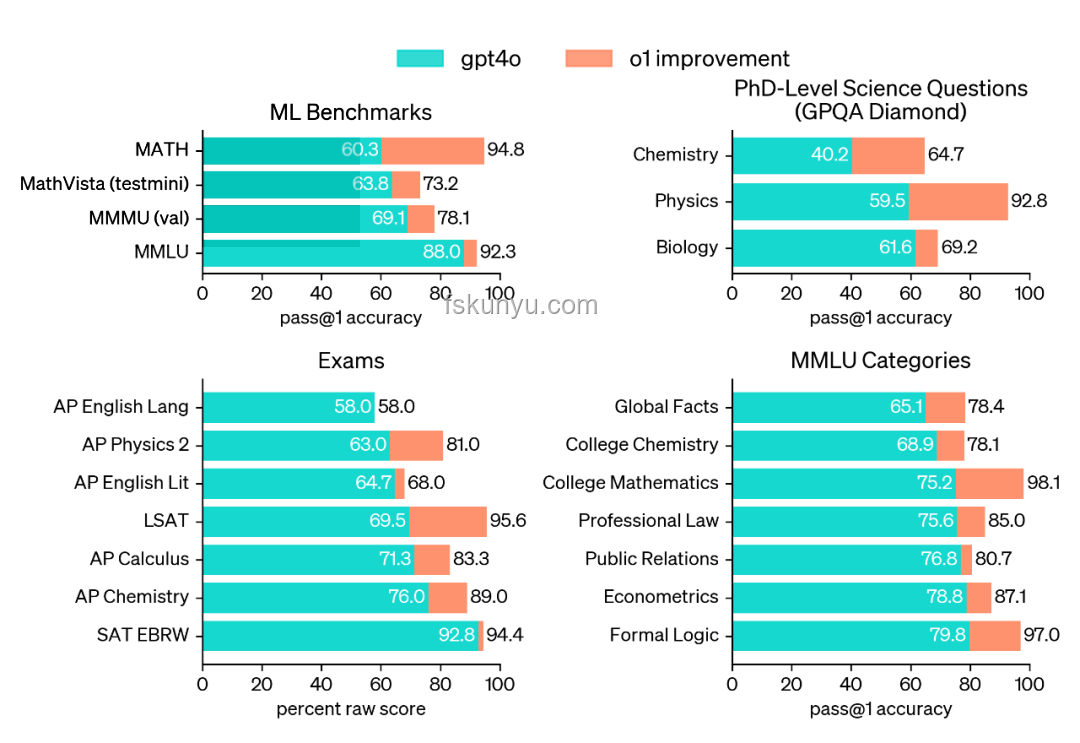

圖示:OpenAI o1自弈強化學習示意圖,展示了智能體通過自弈機制不斷學習和優(yōu)化策略的過程。

在AI技術日新月異的今天,OpenAI的o1自弈強化學習技術無疑為我們打開了一扇新的大門。通過探索這一創(chuàng)新技術,我們不僅能夠推動RL領域的進步,還能夠激發(fā)更多跨界融合的創(chuàng)新思維。讓我們攜手共進,共同探索AI技術的無限可能!

圖示:OpenAI o1自弈強化學習示意圖,展示了智能體通過自弈機制不斷學習和優(yōu)化策略的過程。

在AI技術日新月異的今天,OpenAI的o1自弈強化學習技術無疑為我們打開了一扇新的大門。通過探索這一創(chuàng)新技術,我們不僅能夠推動RL領域的進步,還能夠激發(fā)更多跨界融合的創(chuàng)新思維。讓我們攜手共進,共同探索AI技術的無限可能!

文章評論 (5)

發(fā)表評論