一、問題定義

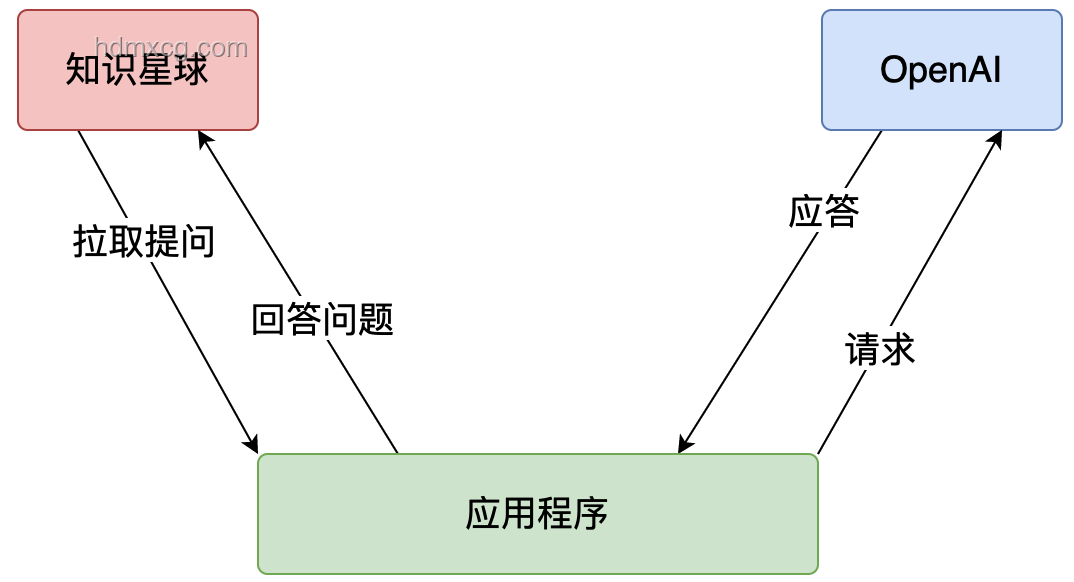

OpenAI o1作為一款融合強化學習(RL)與大型語言模型(LLM)的創新產品,其技術原理復雜且獨特。本文旨在通過逆向工程圖解的方式,深入剖析o1的工作原理,為開發者和技術愛好者提供清晰的技術解析與實施指南。

二、o1技術原理概覽

2.1 強化學習與LLM的融合

o1的核心在于將強化學習與大型語言模型相結合,通過生成Hidden COT(Chain of Thought)來增強邏輯推理能力。這一過程不僅提高了模型的準確性,還賦予了模型自我反思與錯誤修正的能力。

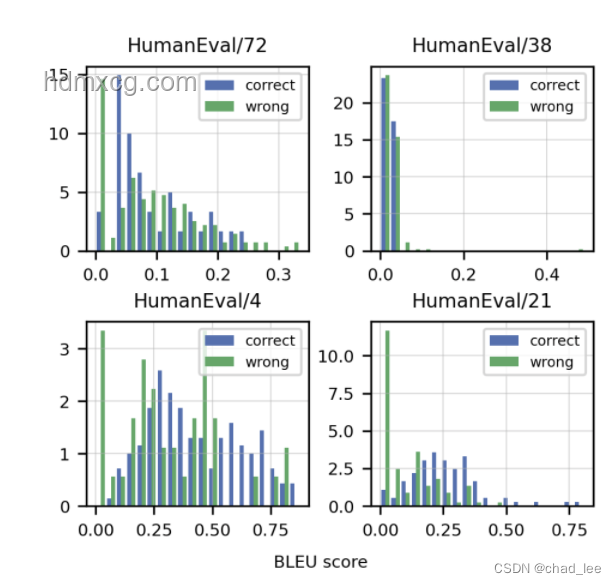

2.2 自我反思與錯誤修正

與傳統的LLM相比,o1在生成答案的過程中能夠意識到之前的錯誤,并進行自動修正。這種能力對于長鏈條思考及解決復雜任務至關重要,極大提升了LLM的實用性。

三、逆向工程圖解o1技術原理

3.1 強化學習機制分析

3.1.1 樹搜索結構的應用

o1可能采用了類似AlphaGo的MCTS(蒙特卡洛樹搜索)或簡單樹結構拓展(如Best-of-N Sampling)等策略。這些樹搜索結構使得o1能夠在復雜的邏輯推理任務中找到最優解。 實施步驟:

- 分析o1的輸出,識別其是否采用了樹搜索結構。

- 通過對比實驗,驗證不同樹搜索策略對o1性能的影響。 優缺點分析:

- 優點:提高了模型的邏輯推理能力和準確性。

- 缺點:增加了模型的復雜性和計算成本。

3.1.2 新型的RL Scaling law

o1通過控制搜索空間大小(如搜索的寬度和深度)來提升模型能力,這種可擴展性極好的方法被稱為新型的RL Scaling law。 實施步驟:

- 調整o1的參數配置,觀察其對模型性能的影響。

- 通過實驗驗證不同參數配置下的模型表現,找到最優配置。 優缺點分析:

- 優點:靈活可擴展,易于通過增加算力提升效果。

- 缺點:參數配置復雜,需要豐富的實驗經驗。

3.2 LLM與RL的融合機制

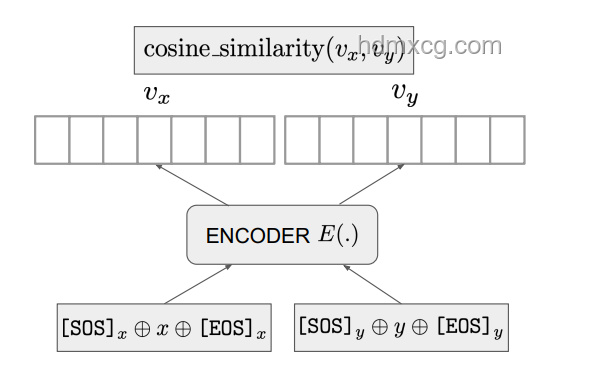

3.2.1 Hidden COT的生成

o1通過融合LLM與RL來生成Hidden COT,這一過程是o1技術原理的關鍵所在。Hidden COT不僅展示了模型的推理過程,還提高了答案的準確性。 實施步驟:

- 分析o1生成的Hidden COT,理解其推理過程。

- 嘗試在自定義任務中生成Hidden COT,驗證o1的推理能力。 優缺點分析:

- 優點:提高了模型的透明度和可解釋性。

- 缺點:增加了模型的計算負擔和輸出長度。

3.2.2 語言、世界知識與邏輯推理的解耦

o1通過解耦語言、世界知識與邏輯推理三個能力,使得小模型也能具備強大的邏輯推理能力。這一方法為小模型的技術發展提供了新的思路。 實施步驟:

- 采用“能力分治”(DCA)模式,將語言、世界知識與邏輯推理能力分開訓練。

- 結合o1的技術原理,優化小模型的邏輯推理能力。 優缺點分析:

- 優點:降低了小模型的技術門檻,提高了其實用性。

- 缺點:需要額外的訓練和優化步驟,增加了開發成本。

四、預防建議與后續措施

4.1 預防建議

- 在應用o1技術時,應充分考慮模型的計算成本和資源需求,避免過度消耗資源。

- 在訓練和優化模型時,應注重數據的多樣性和質量,以提高模型的泛化能力。

4.2 后續措施

- 持續關注OpenAI o1的技術更新和社區反饋,不斷優化和改進自己的模型。

- 探索將o1技術應用于更多領域和場景,如自然語言處理、智能問答、推薦系統等。

五、常見問答(Q&A)

Q1:o1是如何實現自我反思與錯誤修正的? A1:o1通過融合強化學習與大型語言模型,生成Hidden COT來展示推理過程。在推理過程中,o1能夠識別并修正之前的錯誤,從而實現自我反思與錯誤修正。 Q2:o1的強化學習機制有哪些特點? A2:o1的強化學習機制可能采用了樹搜索結構(如MCTS或Best-of-N Sampling)和新型的RL Scaling law。這些特點使得o1能夠在復雜的邏輯推理任務中找到最優解,并通過調整參數配置來提升模型性能。 Q3:如何將o1的技術原理應用于小模型? A3:可以采用“能力分治”(DCA)模式,將語言、世界知識與邏輯推理能力分開訓練。結合o1的技術原理,優化小模型的邏輯推理能力,使其具備更強的實用性。 通過以上逆向工程圖解與分析,我們對OpenAI o1的技術原理有了更深入的理解。希望本文能為開發者和技術愛好者提供有價值的參考與指導。

文章評論 (1)

發表評論